Нейросети сегодня — это основа приложений самых разных сфер: от распознавания лиц и обработки медицинских снимков до стратегий финансовых рынков и автономного транспорта. Они оказываются в центре инноваций, но одновременно становятся мишенью целевых атак, которые эксплуатируют особенности обучения и внутренней структуры моделей. Такие атаки уже перестали быть теоретической проблемой — исследователи и хакеры демонстрируют их потенциальную опасность, как в академических публикациях, так и в реальных экспериментах.

Часто эти уязвимости возникают потому, что нейросети «обучаются» на статистических закономерностях данных, а не на истинной семантике — это делает их чувствительными к малейшим изменениям входных данных, которые человек может не заметить.

Ниже мы разберём, какие типы атак существуют, как они реализуются, а затем — как современные методы защиты помогают нейросетям выживать в сложной среде угроз. Постараемся сделать это максимально конкретно, с примерами и чёткими классификациями.

Почему нейросети уязвимы

Нейросети основаны на оптимизации весов через многослойную структуру, что позволяет им выявлять скрытые зависимости в данных. Однако такой подход создаёт противоречие: модель учится тому, что есть в данных, а не тому, что человек считает «логичным» или «правильным». Это приводит к ситуации, когда малейшие манипуляции с входом могут радикально изменить результат предсказания, особенно если атакующий знает, как устроена система.

Основные категории атак нейросетей

Атаки на нейросети можно классифицировать по разным признакам: по доступу к модели, по цели, по этапу жизненного цикла модели и по тому, как они воздействуют на данные. Ниже приведён классификационный список.

⟶ Классификация атак

По доступу к модели:

- White-box-атаки — атакующий знает внутреннюю структуру нейросети и её параметры.

- Black-box-атаки — атакующий не знает внутренней архитектуры, но может наблюдать результаты модели.

По цели атаки:

- Подмена результата — модель возвращает неправильный ответ (например, классификатор путём небольшого изменения видит другое).

- Отказ в обслуживании (DoS) — модель перестаёт работать корректно на определённых входах.

- Инъекция подсказок (Prompt injection) — злоумышленник изменяет поведение языковых моделей через вводимые команды или структуры вопросов.

По этапу атаки:

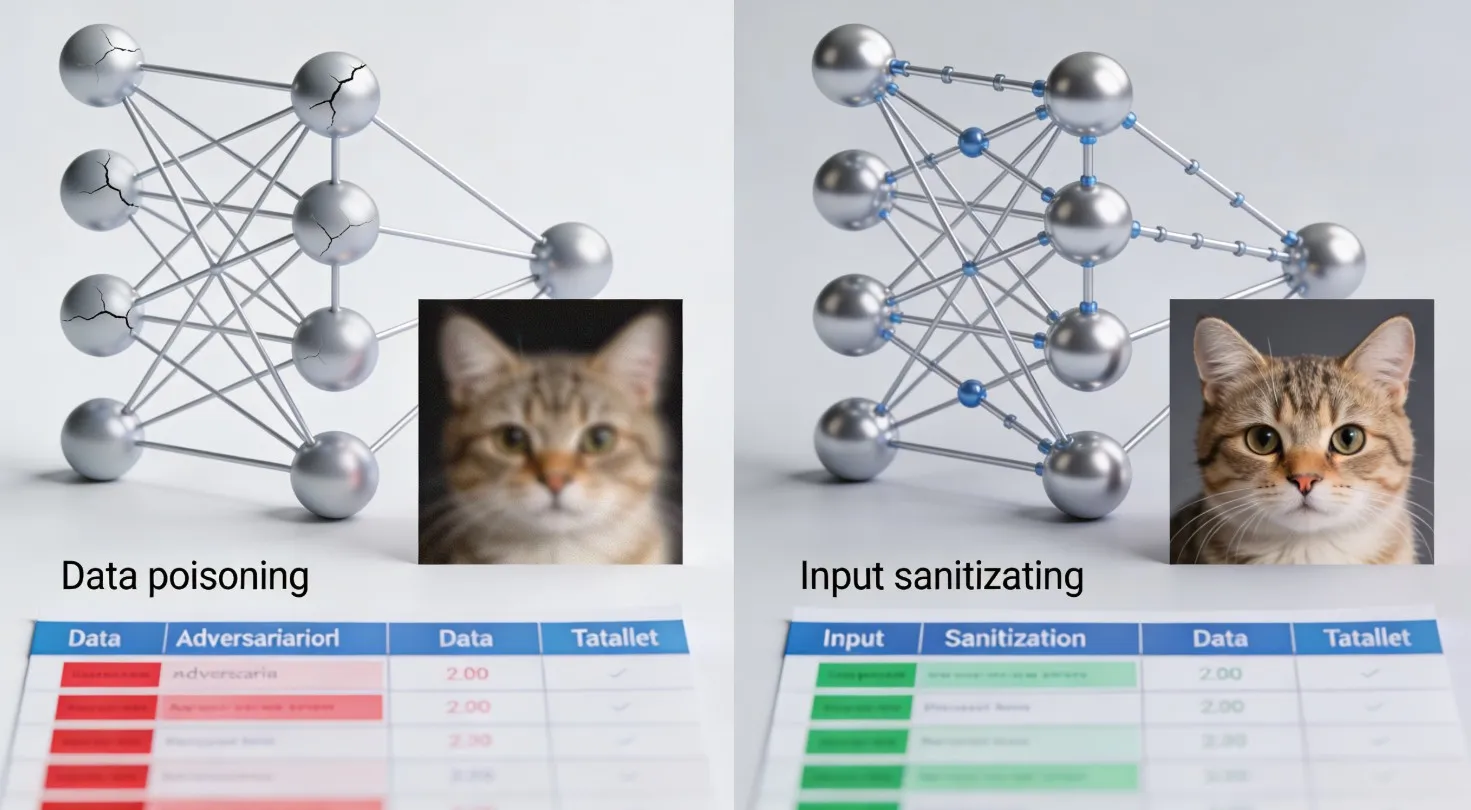

- Во время обучения (Poisoning / Backdoor) — изменение тренировочных данных, чтобы модель усвоила скомпрометированное поведение.

- Во время работы (Inference-time attacks) — атаки на входные данные уже обученной модели (адверсариальные примеры).

Примеры конкретных атак

Ниже — список задокументированных атак, которые демонстрируют, как нейросети вводят в заблуждение и как это используется злоумышленниками.

➤ Список конкретных атак

- Adversarial example — модификация входного изображения так, что нейросеть ошибочно классифицирует объект (например — изображение панды распознаётся как гиббон).

- Black-box-атакa с substitute-model — построение локальной копии модели и использование её для генерации примеров, которые обманывают удалённую модель.

- Prompt injection — изменение текстовых инструкций так, что модель выполняет нежелательные действия (влияние на ответы LLM).

- Backdoor-атака — вставка триггеров в тренировочные данные, которые приводят к включению скрытых функций при определённых условиях.

- Transferability attacks — использование примеров, созданных для одной модели, чтобы обмануть другую.

- Universal perturbations — обобщённые модификации, которые влияют на множество входов сразу.

- Gradient-based attacks — использование градиентов нейросети для вычисления направлений, которые максимизируют ошибку модели.

Что такое адверсариальные примеры

Адверсариальные примеры — это искусственно созданные входные данные, которые выглядят нормально человеку, но приводят нейросеть к ошибочному выводу. Это одна из самых изученных и опасных категорий атак на нейросети сегодня.

Суть таких атак в том, что небольшие, зачастую незаметные изменения (например, в пикселях изображения) меняют выход модели на полностью другой класс, даже если человеку объект всё ещё видится правильно. Эксперименты показывают, что модели могут ошибаться с экстремальной уверенностью — например, уверенно называть один объект совершенно другим.

Типы атак vs их последствия и примеры

| Категория атаки | Пример реализации | Как проявляется | Применение/опасность |

|---|---|---|---|

| Adversarial example | Изображение панды → гиббон | Модель ошибается | Обман систем распознавания |

| Black-box attack | Substitute-model | Модель неверно классифицирует без знаний кодов | Уязвимость API и облачных моделей |

| Prompt injection | Изменение инструкций LLM | Непреднамеренные ответы, обход ограничений | Манипуляция генерацией контента |

| Backdoor | Тренировка с вставленным триггером | Срабатывает на специфическом сигнале | Скрытые команды и скрытые правила |

| Transferability | Перенос примеров на другие модели | Ошибки на разных архитектурах | Универсальные угрозы |

| Gradient attacks | Использование градиента | Высокая точность атаки | Угроза для автомобильных и медицинских ИИ |

| Universal perturbations | Общий шум для множества входов | Сбой для многих данных | Массовые атаки |

Источник классификации атак и методов — обзорные исследования уязвимостей и методов защиты нейросетей.

Почему это важно: реальные последствия атак

Атаки на нейросети — это не абстрактная проблема:

- ИИ в медицине: ошибки классификации снимков из-за атак могут привести к неверному диагнозу, что представляет серьёзную угрозу здоровью.

- Автономные системы: атаки на системы восприятия автомобиля могут заставить его неверно реагировать на дорожные знаки.

- Языковые модели: инъекция подсказок позволяет обходить встроенные ограничения и получать нежелательный контент или манипулировать пользователями.

- Кибербезопасность: модели, которые анализируют угрозы, сами могут быть атакованы через модификации поведения киберпреступников.

Методы защиты нейросетей

Современные методы защиты стремятся сделать модели устойчивыми и менее чувствительными к злонамеренным вмешательствам. Ниже — основные стратегии, используемые в практике и исследованиях.

⟶ Основные техники защиты

- Adversarial Training (сostavное обучение)

— модель обучается также на атаках, что повышает устойчивость. - Дифференциальная приватность

— добавление шума в процесс обучения для защиты личных данных и снижение возможности вмешательства. - Интерпретируемость и Explainable AI (XAI)

— анализ моделей для выявления слабых мест и понимания причин ошибок. - Защитные алгоритмы

— специальные системы мониторинга и корректировки, отслеживающие аномалии входов. - Масштабный анализ данных

— непрерывный контроль качества входных данных и системы обучения.

Ограничения существующих методов

Хотя стратегии защиты помогают, ни одна из них не даёт полного гарантированного результата. Многие методы успешно защищают от некоторых видов атак лишь частично, и потенциально может возникнуть новая техника атаки, способная обойти текущие меры.

Часто возникают компромиссы между устойчивостью и точностью модели: более жёсткая защита может снизить производительность ИИ в нормальных задачах. Поэтому разработчики вынуждены балансировать между безопасностью и качеством сервиса.

Заключение

Атаки на нейросети — это реальная и растущая угроза, которая затрагивает безопасность ИИ в самых критичных областях: от медицины до автономного транспорта и анализа данных. Понимание разновидностей атак, их примеров, мотивов и методов защиты — ключевой шаг для построения безопасных и надёжных нейросетевых систем.

Хотя текущие методы защиты помогают уменьшить уязвимости, ни один из них не является универсальным решением. Это делает область безопасности нейросетей одной из наиболее динамичных и исследовательски активных, где каждое новое поколение моделей усиливает потребность в более сложных и продуманных механизмах защиты.